Accélérateurs de particules : toujours plus grands pour sonder l’infiniment petit

L’exploration de l’infiniment petit a progressé de manière fulgurante : on distingue aujourd’hui des détails cent millions de fois plus fins qu’au début du XXe siècle. Cette connaissance a franchi les étapes de l’atome puis du noyau puis des nucléons pour aboutir aux constituants élémentaires.

Par Francois Vannucci, Professeur émérite, chercheur en physique des particules, spécialiste des neutrinos, Université Paris Diderot – USPC

Read more: Voyage au cœur de la matière : mesurer l’infiniment petit

Alors quelle suite envisager ? Le 15 janvier dernier, une collaboration internationale a rendu publique l’étude d’un futur collisionneur circulaire (FCC) à construire au CERN (Organisation européenne pour la recherche nucléaire). Après la découverte du boson de Higgs au LHC annoncée en 2012, les complexes accélérateurs du futur s’esquissent déjà.

Accélérer plus vite pour voir plus petit

Les dimensions de l’infiniment petit sont directement reliées aux énergies disponibles : plus on tape fort, plus on voit des détails fins. L’unité d’énergie en usage est l’électron-volt (eV), qu’acquiert une charge dans un potentiel de 1 V. Les rayons X vont jusqu’à 100 keV (kilo), la radioactivité tourne autour du MeV (méga). Dans les années 1950, les accélérateurs arrivèrent au GeV (giga), et le LHC atteint le record actuel avec 6,5 TeV (téra).

Ernest Rutherford révéla le noyau atomique, au début du XXe siècle, en soumettant la matière à un rayonnement nucléaire. De même, les chercheurs sondent aujourd’hui des dimensions de 10-18 mètre grâce à des faisceaux de plusieurs centaines de GeV. La relation entre énergie de la sonde et échelle explorée dérive de la mécanique quantique. À chaque particule on associe une onde dotée d’une longueur inversement proportionnelle à l’énergie. Le principe de Heisenberg lie énergie et dimension selon la formule hc = 200 MeV fm, (le fm, femtomètre, vaut 10-15 mètres). Cela donne la plage des énergies utilisées : un faisceau de 200 MeV sonde le niveau de 1 fm, 2 GeV sonde 0,1 fm… La course vers l’infiniment petit explique donc l’usage des accélérateurs.

Une brève histoire des accélérateurs

Les particules chargées et stables sont accélérées dans un champ électrique. En pratique, les premiers accélérateurs s’appliquèrent aux protons et aux électrons, puis la technique s’étendra aux antiprotons et aux positrons (les antiparticules du proton et électron portant des charges opposées) ainsi qu’aux ions.

Dans les années 1930 l’accélérateur Van de Graaf accumule mécaniquement des charges sur un conducteur. Avec 10 mètres de long, il accélère des protons jusqu’à 10 MeV ; au-delà les décharges électriques deviennent rédhibitoires.

En 1939, E. O. Lawrence invente le cyclotron. L’idée est de forcer les particules à traverser de multiples fois un champ. Ainsi la tension reste modérée, la particule augmentant graduellement son énergie à chaque nouveau passage. La technique nécessite un champ magnétique forçant un parcours circulaire qui ramène les particules dans les enceintes adéquates. Le cyclotron est constitué d’une cavité circulaire divisée en deux moitiés entre lesquelles règne une tension alternative, le tout baigne dans un champ magnétique axial. Les particules suivent des cercles de plus en plus grands. Le temps d’un demi-tour reste constant, la longueur accrue du trajet étant compensée par l’augmentation de la vitesse. Ceci fixe la fréquence de la tension. Le diamètre du dispositif fixe la limite pour des protons de quelque 10 MeV.

Mais les effets relativistes augmentent la masse des particules et à haute énergie le cyclotron n’est plus accordé (il n’est plus en phase avec le passage des particules). Le champ magnétique doit alors varier en continu.

D’où l’idée de passer aux synchrotrons en fixant le rayon de la machine. Les particules décrivent alors une même circonférence grâce à des aimants beaucoup plus petits, mais il faut des champs magnétiques variables, croissant avec l’accélération. Un calculateur de gestion devient obligatoire. Cette technique a un corollaire : alors que le cyclotron produit un faisceau de manière continue, la modulation du champ magnétique implique un régime impulsionnel.

Ainsi seront construits le Cosmotron de 3 GeV à Brookhaven près de New York, et le Bevatron de 5 GeV à Berkeley qui découvrit l’antiproton en 1955. Affaire de prestige national, le record fut détenu par le laboratoire de Dubna près de Moscou avec 10 GeV. C’est alors que fut mis au point le concept de « focalisation forte ». Une suite d’aimants astucieusement assemblés permettait d’obtenir des faisceaux beaucoup plus fins. Cette technique enchaîne une maille à l’envers une maille à l’endroit, comme au tricot, les aimants étant tour à tour focalisant et défocalisant. Cette astuce réduisait la taille des aimants et permettait de concevoir une machine circulaire plus ambitieuse. Sur cette idée, le CERN et Brookhaven se lancèrent le même défi : construire l’accélérateur le plus puissant permis par la technologie du moment.

Le CERN fit la course en tête. Son PS (Proton Synchrotron) accéléra le premier des protons jusqu’à l’énergie pic de 28,3 GeV en 1959. Puis Brookhaven parvint à 30 GeV avec son AGS (Alternating Gradient Synchrotron). Ces deux machines ont une taille déjà imposante ; le PS aligne 277 aimants qui se suivent à la queue leu leu sur une circonférence de 628 m.

Le PS accélérant des protons, il permettait de produire des faisceaux variés. Des protons accélérés engendrent toutes sortes de particules secondaires : beaucoup de pions et de kaons (particules à vie brèves appelées mésons) mais aussi des neutrons et des photons. Par manipulation, on obtient des faisceaux de particules tertiaires tels qu’électrons et positrons, muons et neutrinos offrant un ample éventail de recherches à un grand nombre d’expériences.

Qu’est-ce qu’un collisionneur ?

La physique des particules a longtemps bombardé une cible avec des particules de plus en plus énergiques. Mais un autre but était toujours présent : la création de particules nouvelles. La relativité permet la création d’objets massifs à partir d’énergie selon la relation d’Einstein E = mc2. Une expérience sur cible fixe un lieu dans le « repère du laboratoire », celui où travaille le physicien. Dans une telle configuration, l’énergie de la particule entrant produit des particules secondaires en leur donnant un mouvement, elles sont globalement émises dans la direction du projectile. L’énergie de mouvement est gaspillée et pour éviter cette perte on inventa les collisionneurs.

Dans un premier temps, un collisionneur consistait à accélérer une particule et son antiparticule dans des directions opposées. Un anneau unique suffit puisque particules et antiparticules tournent en sens inverse dans un même circuit électromagnétique. Des instruments pionniers, électron-positron, furent construits, d’abord à Frascati près de Rome, puis à Orsay. Dans cette configuration, les deux particules mères possèdent des quantités de mouvement opposées. La collision a lieu dans le « repère du centre de masse ». Ceci crée des particules de masses élevées, car l’énergie initiale peut être complètement convertie en masse, rien n’est perdu en mouvement. Ainsi l’énergie équivalente que devrait avoir un proton bombardant un proton fixe pour égaler l’énergie utile offerte au LHC, équivaudrait à 100 000 TeV. Totalement irréalisable !

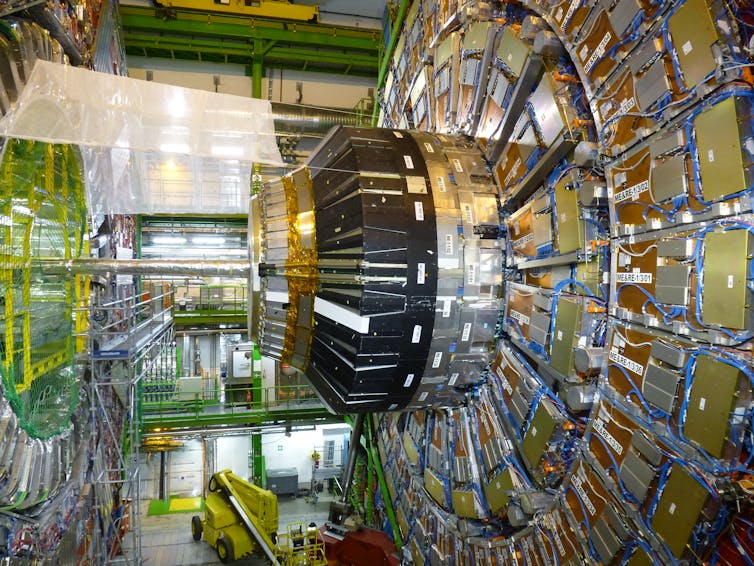

Enfin arriva le LHC, couronnement de la technique en mode proton-proton de 6,5 TeV d’énergie par faisceau. La première motivation était la découverte du boson de Higgs. Le mécanisme de Higgs permet l’unification des interactions électromagnétique et faible au sein de la théorie électrofaible ; il est à l’origine de la différenciation des masses des particules. Le LHC est assemblé dans le tunnel de 27 km hérité du LEP. C’est un anneau de 1 232 aimants supraconducteurs fonctionnant à 1,7 Kelvin (soit à peine plus que la température du zéro absolu) de 6 mètres de long et pesant 30 tonnes. Découvrir le Higgs demanda vingt ans !

Gigantisme, démesure ; pour atteindre ses objectifs, la physique des particules approche les chronologies caractéristiques des cathédrales médiévales. Une génération de fidèles concevait l’édifice, la suivante la construisait et enfin la troisième pouvait profiter des lieux tout en continuant à décorer l’intérieur. Le Higgs est découvert, c’est heureux mais tout n’est pas résolu. L’une des insatisfactions de fond provient du fait que les paramètres libres du modèle standard sont en très grand nombre et de valeurs semble-t-il arbitraires. Et puis nous vivons avec les énormes énigmes de la masse manquante, l’énergie noire et la disparition de l’antimatière. Alors que faire ?

Et voilà le future circular collider

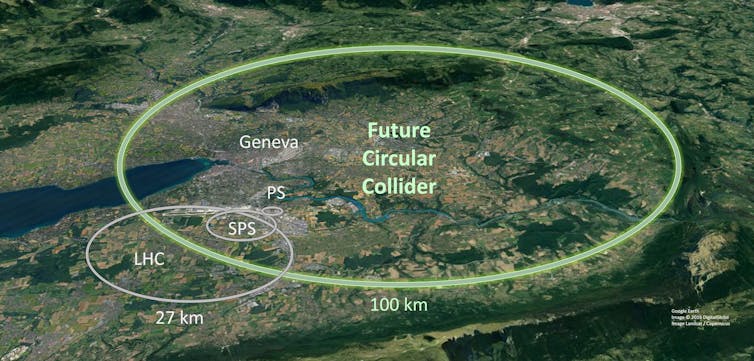

Toute communauté constituée œuvre pour sa survie, et les physiciens des particules ont défini leur stratégie à long terme. Le future circular collider (FCC) est un formidable nouveau défi tirant avantage des compétences et des infrastructures déjà existantes. L’objectif ultime est de proposer un collisionneur supraconducteur de protons dans un anneau de 100 km de circonférence, capable de fournir une énergie allant jusqu’à 100 TeV. Ce projet permettrait un riche programme qui mobiliserait la communauté durant tout le XXIe siècle.

Le calendrier prévoit de commencer avec une machine électron-positron d’une énergie de 90 à 365 GeV, une « usine à Higgs » ayant une grande sensibilité pour détecter de possibles écarts par rapport aux prévisions du Modèle. Le coût estimé serait de l’ordre de 9 milliards d’euros dont 5 consacrés au génie civil nécessaire à l’excavation du tunnel de 100 km. Cela assurerait la physique pendant 15 à 20 ans au terme de l’exploitation du LHC. Puis une machine supraconductrice proton-proton occuperait le même tunnel pour un coût de 15 milliards, cette machine pouvant commencer à fonctionner à la fin des années 2050 pour tenter de détecter des signes de Nouvelle Physique.

L’effort est devenu colossal pour un progrès qui semble freiné, comme si la connaissance se laissait approcher asymptotiquement. C’est pourtant le devoir du chercheur de sans cesse aller de l’avant sans que le résultat soit assuré. Cette démarche peut sembler idéaliste ; elle n’est pas sans rappeler l’aventure de Christophe Colomb qui justifie sa quête dans un dialogue avec son compagnon Pierre Gutierrez (Petites œuvres morales de Giacomo Leopardi) :

C. Colomb : Ma conjecture, quoique fondée sur des arguments très probables, non seulement personnels, mais de nombreux géographes, astronomes et navigateurs excellents… pourrait faillir. Ceci signifie que beaucoup de conclusions tirées de discours parfaits ne survivent pas à l’expérience.

P. Gutierrez : Ainsi, tu paries ta propre vie et celle de tes compagnons sur la base d’une simple opinion spéculative ?

C. Colomb : Je ne peux le nier… Mais si nous n’étions pas sur ce navire, ne serions-nous pas dans un tourment majeur… ou plein d’ennui ? Que veut dire un état libre d’incertitude et de danger ?… Cette navigation nous est très profitable, au moins parce qu’elle nous tient libre d’ennui et nous rend la vie chère… Et si la cime d’un mont se découvre au loin, il nous semblera vivre des jours bienheureux.

Francois Vannucci, Professeur émérite, chercheur en physique des particules, spécialiste des neutrinos, Université Paris Diderot – USPC

This article is republished from The Conversation under a Creative Commons license. Read the original article.